Nvidia heeft Nemotron-4 340B gepresenteerd, een familie van open-source taalmodellen ontworpen om hoogwaardige synthetische gegevens te genereren en krachtige AI-applicaties in verschillende industrieën te ontwikkelen.

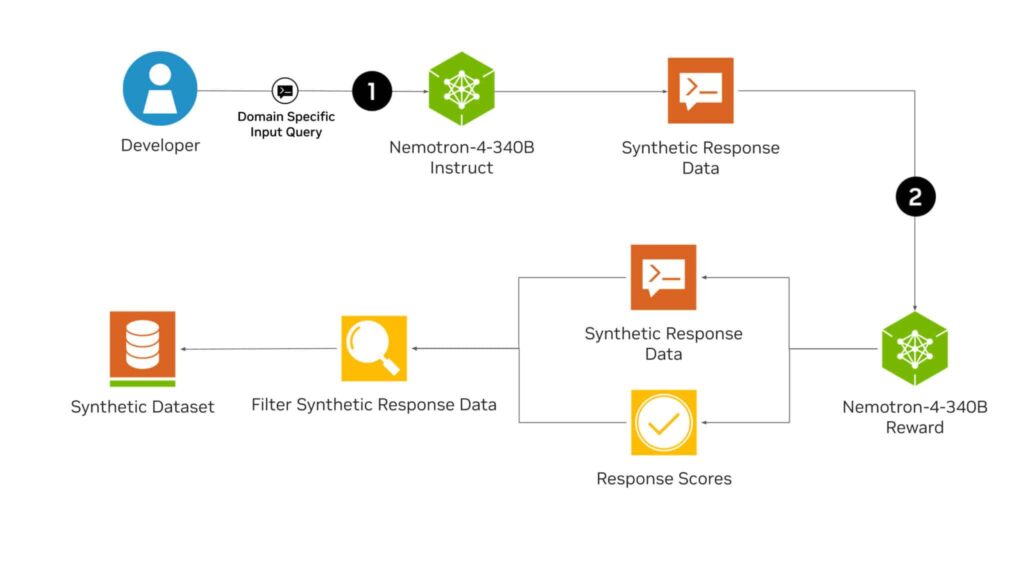

De Nemotron-4 340B familie omvat drie sleutelmodellen: Basis, Instruct en Reward, die een keten vormen om synthetische data te creëren die gebruikt worden in de training van nieuwe large language models (LLM’s). Het Instruct-model genereert hoogwaardige synthetische data en is getraind met 98% synthetische data, terwijl het Reward-model deze data filtert om de meest kwalitatieve voorbeelden te selecteren.

De Nemotron-4 modellen hebben bewezen competitief te zijn en zelfs superieur aan andere open-source modellen zoals Llama-3, Mixtral en Qwen-2 in verschillende benchmarktests. Bovendien heeft Nvidia Mamba-2 Hybrid uitgebracht, een selective state space model (SSM) dat transformer-gebaseerde LLM’s in nauwkeurigheid heeft overtroffen.

Nvidia heeft niet alleen een familie van open-source modellen geleverd die gelijk zijn aan de capaciteiten van hun belangrijkste concurrenten, maar excelleert ook in het creëren van synthetische data die nodig zijn om vooruitgang te blijven boeken in de ontwikkeling van nieuwe LLM’s. De chipproductiegigant blijft zich vestigen als een kracht in het veld van kunstmatige intelligentie.

De lancering van de Nemotron-4 340B Familie

Nvidia heeft aangekondigd dat de Nemotron-4 340B-modellen zijn geoptimaliseerd om samen te werken met Nvidia NeMo, een open-source framework voor end-to-end training van modellen, en met de open-source bibliotheek Nvidia TensorRT-LLM voor inferentie.

Ontwikkelaars kunnen Nemotron-4 340B downloaden van Hugging Face en binnenkort zullen ze beschikbaar zijn op ai.nvidia.com, waar ze als Nvidia NIM-microservice verpakt zullen worden met een standaard application programming interface die overal ingezet kan worden.

Generatie van Synthetische Data met Nemotron

LLM’s kunnen ontwikkelaars helpen bij het genereren van synthetische trainingsdata in scenario’s waar toegang tot grote en diverse gelabelde datasets beperkt is. Het Instruct-model van Nemotron-4 340B creëert diverse synthetische data die de kenmerken van echte wereldgegevens nabootsen, waardoor de datakwaliteit verbetert om de prestaties en robuustheid van op maat gemaakte LLM’s in verschillende domeinen te vergroten.

Om de kwaliteit van door AI gegenereerde data nog verder te verbeteren, kunnen ontwikkelaars het Reward-model van Nemotron-4 340B gebruiken om reacties van hoge kwaliteit te filteren. Dit model beoordeelt reacties op vijf kenmerken: bruikbaarheid, correctheid, samenhang, complexiteit en wijdlopigheid. Het staat momenteel op de eerste plaats in de RewardBench-leaderboard van Hugging Face, opgezet door AI2.

Optimalisatie en Afstemming met NeMo en TensorRT-LLM

Dankzij de open-source tools Nvidia NeMo en Nvidia TensorRT-LLM kunnen ontwikkelaars de efficiëntie van hun Instruct- en Reward-modellen voor de generatie van synthetische data en de evaluatie van reacties optimaliseren.

Alle Nemotron-4 340B-modellen zijn met TensorRT-LLM geoptimaliseerd om tensorparallellisme te benutten, een vorm van modelparallellisme waarbij de individuele gewichtsmatrices verdeeld worden over meerdere GPU’s en servers, wat een efficiënte inferentie op schaal toestaat.

Veiligheidsevaluatie en Start

Het Instruct-model van Nemotron-4 340B is door een uitvoerige veiligheidsevaluatie gegaan, inclusief adversarial testing, en heeft goed gepresteerd over een brede reeks risico-indicatoren. Gebruikers wordt echter aanbevolen een zorgvuldige beoordeling van de modeluitvoer uit te voeren om te waarborgen dat de gegenereerde synthetische data geschikt, veilig en nauwkeurig zijn voor hun toepassing.

Ontwikkelaars kunnen de Nemotron-4 340B-modellen via Hugging Face downloaden en toegang krijgen tot meer details in de onderzoekspapers over het model en de dataset. Deze innovatie van Nvidia belooft de generatie van synthetische data te transformeren en de ontwikkeling van AI-applicaties in meerdere sectoren.